IT存儲網(wǎng)絡(luò)運維 | InfiniBand技術(shù)簡介

2020-04-09 09:15 作者:艾銻無限 瀏覽量:

IT存儲網(wǎng)絡(luò)運維 | InfiniBand技術(shù)簡介

我們經(jīng)常聽到關(guān)于某超算中心架構(gòu)又用了什么先進的技術(shù),而在這些技術(shù)中,InfiniBand技術(shù)則是人們談?wù)撟疃嗟脑掝}。那么InfiniBand到底有多牛? 簡單來說,InfiniBand是一種支持多并發(fā)鏈接的轉(zhuǎn)換線纜技

術(shù),它既可以處理存儲I/O、網(wǎng)絡(luò)I/O,也能夠處理進程間通信(IPC),這樣它即可以將磁盤陣列、SANs、LANs、服務(wù)器和集群服務(wù)器進行互聯(lián),也可以連接外部網(wǎng)絡(luò)(比如WAN、VPN、互聯(lián)網(wǎng))。

1、InfiniBand技術(shù)背景和現(xiàn)狀

設(shè)計InfiniBand的目的主要是用于企業(yè)數(shù)據(jù)中心,大型的或超大型的數(shù)據(jù)中心,為了實現(xiàn)高的可靠性、可用性、可擴展性和高的性能。并且InfiniBand可以在相對短的距離內(nèi)提供高帶寬、低延遲的傳輸,而且在單

個或多個互聯(lián)網(wǎng)絡(luò)中支持冗余的I/O通道,因此能保持?jǐn)?shù)據(jù)中心在局部故障時仍能運轉(zhuǎn)。Infiniband網(wǎng)絡(luò)是一種高帶寬低延時的網(wǎng)絡(luò),相比傳統(tǒng)的以太網(wǎng)絡(luò),最新一代的Infiniband網(wǎng)絡(luò)帶寬可達100Gbps,點到點的

延時低于0.6us。Infiniband網(wǎng)絡(luò)主要用于高性能計算場景,通過高速的Infiniband網(wǎng)絡(luò),將一臺臺多路服務(wù)器構(gòu)建為一個高性能計算集群,集群性能基本上是單臺服務(wù)器性能的線性疊加,可以說正是因為有

Infiniband網(wǎng)絡(luò)技術(shù),才能催生出超算高性能集群架構(gòu)。Infiniband交換機可以分別帶管理交換機和不帶管理交換機,帶管理交換機有硬件管理端口,對整個網(wǎng)絡(luò)的管理可以通過交換機硬件完成,通常一個項目中

會配置少量的帶管理交換機(兩臺)。

2、InfiniBand為超算中心提供超強傳輸性能

有鑒于此,越來越多的超算中心開始大量采用InfiniBand技術(shù),尤其是在對傳輸性能要求非常高的數(shù)據(jù)中心中,應(yīng)用非常廣泛。近日,全球知名的InfiniBand解決方案提供商Mellanox公司市場副總裁Gilad Shainer

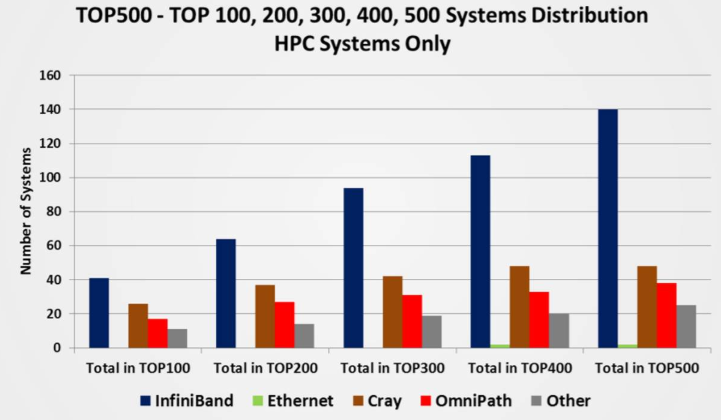

先生接受了記者專訪時,詳細闡述了InfiniBand 解決方案的市場競爭力及為全球用戶企業(yè)提供的全新性能和可擴展性。當(dāng)今超算TOP500的排名中,在Intersect360調(diào)查中,約2/3的受訪系統(tǒng)上部署安裝了以太網(wǎng)和

InfiniBand。這顯示,InfiniBand解決方案依然在高性能計算領(lǐng)域占有著絕對的市場份額,遠遠高于高性能計算系統(tǒng)里面的其他網(wǎng)絡(luò)互聯(lián)廠商。

Mellanox的InfiniBand的解決方案占據(jù)了近一半的市場份額,高達46%的份額,這充分例如顯示了在高性能計算系統(tǒng)里面Mellanox的網(wǎng)絡(luò)依然是一個絕對領(lǐng)先的高速網(wǎng)絡(luò)。而在2016年TOP500里面新建的系統(tǒng)中,

有65個選擇了Mellanox的產(chǎn)品,在2019年最新TOP500列表中,InfiniBand份額為28%(140個系統(tǒng))。但是,從性能的角度來看,基于InfiniBand的計算網(wǎng)絡(luò)占TOP500總體性能的40%

3、InfiniBand技術(shù)玩家和如今巨頭

InfiniBand Trade Association (IBTA)的9個主要董事成員中只有Mellanox和Emulex專門在做InfiniBand,其他成員只是扮演了使用InfiniBand的角色。而Emulex由于業(yè)務(wù)不景氣也在2015年的2月被Avago收購,

Qlogic的infiniband業(yè)務(wù)在2012年也全部賣給Intel了,Intel基于此布局OPA。Mellanox在InfiniBand市場一家獨大,其產(chǎn)品的集群部署數(shù)量遠遠大于選擇競爭對手的數(shù)量,選擇Mellanox產(chǎn)品的集群數(shù)量是選擇競爭

對手Omni-Path(英特爾)網(wǎng)絡(luò)的近四倍,是另外一個競爭對手Cray系統(tǒng)的五倍。Mellanox公司提出Co-design(協(xié)同設(shè)計)理念,基于任務(wù)卸載(Offloading)的架構(gòu)能夠讓像RDMA(遠程內(nèi)存直接訪問)這樣的技術(shù)變

得可用,而這傳統(tǒng)的數(shù)據(jù)中心加載(Onloading)架構(gòu)無法做到的。而且采用智能的互連和卸載技術(shù),可以讓高性能計算系統(tǒng)繼續(xù)擴展下去。

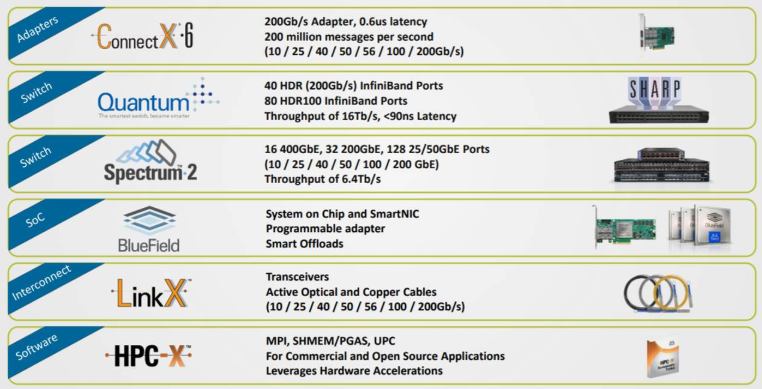

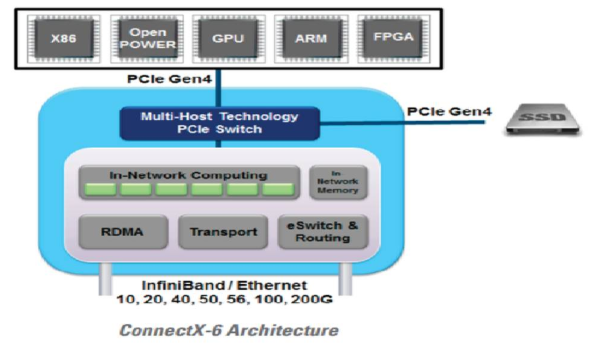

為了讓網(wǎng)絡(luò)來協(xié)助處理數(shù)據(jù),Mellanox不斷去開發(fā)智能網(wǎng)絡(luò),在2019年11月份,Mellanox發(fā)布了全球首個 200Gb/s 數(shù)據(jù)中心網(wǎng)絡(luò)互連解決方案。Mellanox ConnectX-6 適配器、Quantum交換機、 LinkX線纜和收

發(fā)器一同構(gòu)成了面向新一代高性能計算、機器學(xué)習(xí)、大數(shù)據(jù)、云、web 2.0和存儲平臺的完整 200Gb/s HDR InfiniBand 網(wǎng)絡(luò)互連基礎(chǔ)設(shè)施。

ConnectX-6改進了Mellanox的多主機技術(shù),允許最多8臺主機連接到一個適配器將PCIe接口分割成多個獨立的接口。降低了通過減少資本支出(線纜、NIC和交換機端口)和運營成本(減少交換機端口費用)。

Mellanox多主機技術(shù)可用于Mellanox ConnectX10/25/40/50/100千兆以太網(wǎng)和VPI(虛擬協(xié)議互聯(lián))適配器、定制卡和基于OCP主板。200Gb/s HDR InfiniBand 解決方案進一步鞏固了Mellanox的市場領(lǐng)先地位,同時

使客戶和用戶能充分利用基于開放標(biāo)準(zhǔn)的技術(shù),最大程度的提升應(yīng)用程序的性能和可擴展性,同時極大降低數(shù)據(jù)中心的總體擁有成本。Mellanox 200Gb/s HDR InfiniBand Quantum 交換機是全球最快的交換機,

支持 40 端口的 200Gb/s InfiniBand 或 80 端口的 100Gb/s InfiniBand 連接,可實現(xiàn) 16Tb/s 的總交換處理能力,且延遲極低,僅有 90ns(納秒)。Mellanox Quantum 交換機擁有市場上可擴展性最強的交換芯片,

提升了對網(wǎng)絡(luò)內(nèi)計算(in-network computing)技術(shù)的支持,并經(jīng)過優(yōu)化且靈活的路由引擎。為了打造完整的端到端 200Gb/s InfiniBand 基礎(chǔ)架構(gòu),Mellanox還將發(fā)布最新的LinkX 解決方案,為用戶提供一系列不同

長度的 200Gb/s 銅纜及硅光線纜。

以上文章由北京艾銻無限科技發(fā)展有限公司整理

相關(guān)文章

- [網(wǎng)絡(luò)服務(wù)]保護無線網(wǎng)絡(luò)安全的十大

- [網(wǎng)絡(luò)服務(wù)]無線覆蓋 | 無線天線對信

- [網(wǎng)絡(luò)服務(wù)]綜合布線 | 綜合布線發(fā)展

- [數(shù)據(jù)恢復(fù)服務(wù)]電腦運維技術(shù)文章:win1

- [服務(wù)器服務(wù)]串口服務(wù)器工作模式-服務(wù)

- [服務(wù)器服務(wù)]串口服務(wù)器的作用-服務(wù)維

- [服務(wù)器服務(wù)]moxa串口服務(wù)器通訊設(shè)置參

- [網(wǎng)絡(luò)服務(wù)]網(wǎng)絡(luò)運維|如何臨時關(guān)閉

- [網(wǎng)絡(luò)服務(wù)]網(wǎng)絡(luò)運維|如何重置IE瀏覽

- [網(wǎng)絡(luò)服務(wù)]網(wǎng)絡(luò)運維|win10系統(tǒng)升級后

- [辦公設(shè)備服務(wù)]辦公設(shè)備:VPN簡介

- [辦公設(shè)備服務(wù)]辦公設(shè)備:VPN技術(shù)的要求

關(guān)閉

關(guān)閉